详细介绍

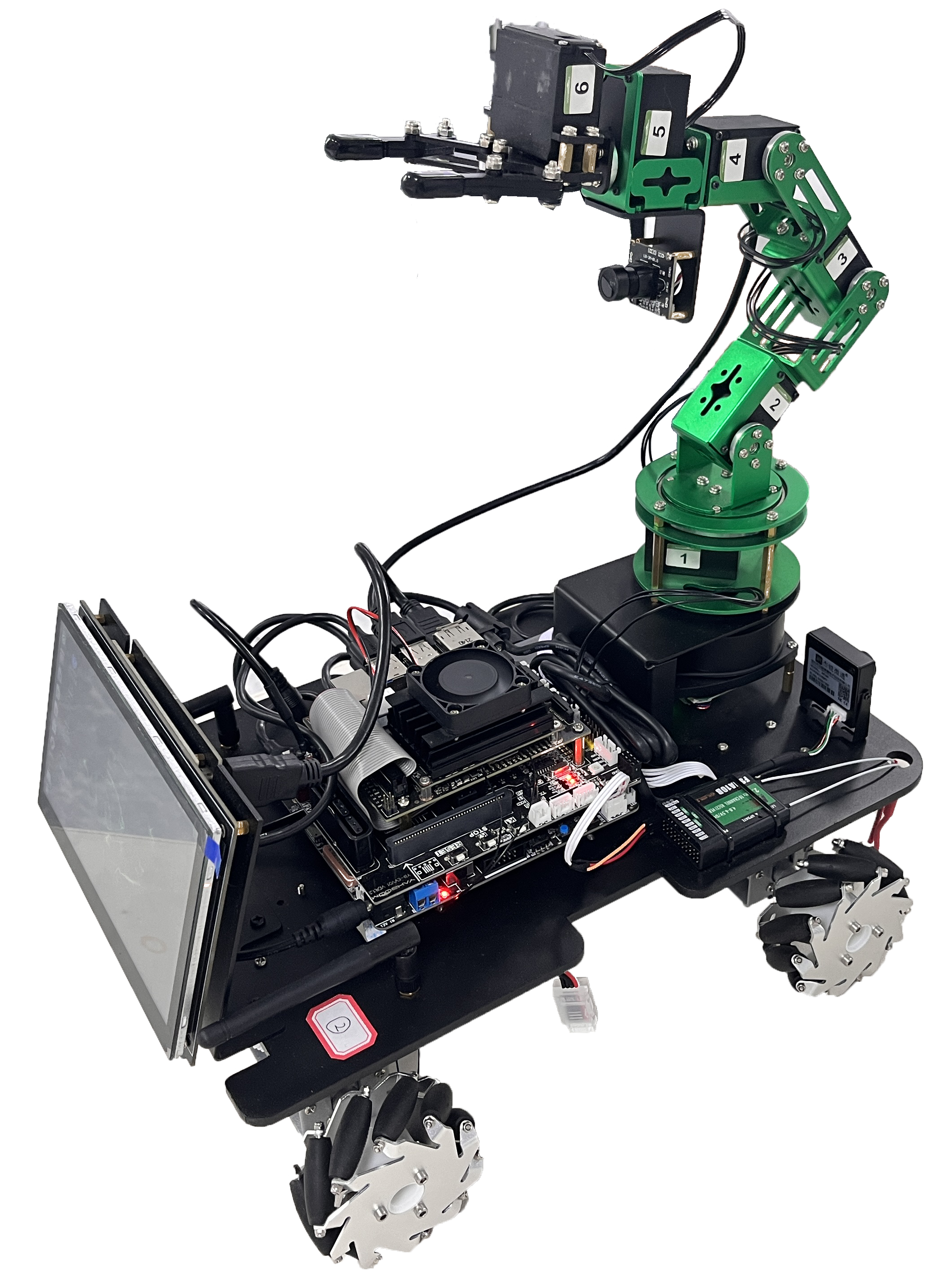

多维运动控制平台以四驱小车为基础,集成电机/舵机驱动控制器,支持小车和机械臂的精准运动控制,同时搭载丰富的传感器实现环境、预警、定位等各种数据的采集和监控,配合无线通信模块,实现人工智能感觉、动作系统的开发和学习。感控单元主控平台采用 STM32 高性能处理器,可完成嵌入式与传感器、机器人控制技术课程的学习。配合智能边缘计算网关,能够完成基于 ROS 系统的机器人协作开发课程的学习。

智能网关:

处理器:64位四核CORTEX-A57,128核MAXWELL GPU;

内存:4GB LPDDR,板载存储:64GB;

接口:USB3.0×4,Micro USB×1, HDMI×1,RJ45×1,DC5.5×2.1电源接口;

集成Linux、Python等运行环境,支持数字图像处理、机器视觉、深度学习等算法、硬件、应用的开发和学习。

搭载 7 寸 LVDS 高清屏。

AI 自动驾驶平台车体不小于 360mm*210mm*350mm,

采用高性能双路 ARM Cortex-M4 STM32G4 控制器单元,

提供电机驱动及传感驱动。

四驱独立悬挂轮式驾驶底盘,大功率减速电机。

(1)运动控制模块

在机器人中用到很多控制器和外设,包括:处理器、激光雷达,STM32控制器,电机、编码器、双路驱动、蓝牙、PS2有线手柄、航模遥控、陀螺仪等,同时提供了串口1和CAN接口方便用户拓展控制,这些控制器与控制器,外设与控制器之间的连接,如图所示。

(2)ROS操作系统

ROS操作系统内置于中央处理器内,通过RTOS完成系统任务调度与管理。具体任务调度管理流程如图所示。RTOS任务调度器根据任务的优先级决定任务的执行顺序,每个任务执行的时间很短,因此几乎等效于所有任务同时执行,期间如果发生中断则去响应中断。串口2中断用于APP蓝牙控制,串口3中断用于接收ROS传过来的信息。

(3)JetsonNano边缘计算平台

NVIDIA Jetson Nano是一个小巧却功能强大的计算机,它可以让你并行运行多个神经网络、对象检测、分割和语音处理等应用程序,Jetson Nano搭载四核cortex-A57处理器,128核MaxwellGPU及4GB LPDDR内存,带来足够的AI计算能力,提供472GFLOP算力,并支持一系列流行的Al框架和算法,比如TensorFlow、Pytorch.caffe/caffe2、Keras、MXNET等

(4)激光雷达

相较于传统技术,利用红外激光设备可实现超大屏幕的多点触摸,其反应更快、精度更高、抗环境光能力更强。激光雷达作为核心传感器,可快速获得环境轮廓信息,配合SLAMWARE使用,可以帮助机器人实现自主构建地图、实时路径规划与自动避开障碍物。应用领域智能扫地机、家用机器人。

测量半径:12米,测量频率:8000次/秒,扫描频率:5.5HZ,360度扫描测距

(5)机器视觉-双目深度体感摄像头

双目深度体感摄像头是VR/AR、机器人和无人驾驶最核心的技术支撑之一,而深度摄像头就是这类硬件的眼睛。只有机器对“看到的”东西,定位定姿精度更高时,才能更好地识别和做出判断,从而提升机器的可用性和产品化速度。利用双目立体视觉成像原理实现三维定位,即可进行手势、肢体动作的综

使用距离:0.8m至 3.5m之间,视野:58° H, 45 V, 70° D(水平,垂直,对角),传感器:深度,深度影像大小:VGA(640x480) : 30fps,QVGA (320x240): 60fps,接口:USB2.0

(7)六自由度机器臂

视觉机械臂以Jetson Nano为主控,Open Source CV为图像处理库,以主流的Jupyter Lab为开发工具,使用Python3为主要编程语言。摄像头与机械臂机身一体式设计,“手眼合一”的视觉识别让机械臂显得更加灵动,它不仅可以实现颜色识别追踪与抓取,还能人体特征识别互动,甚至进行垃圾分类模型训练垃圾分拣;通过RO5机器人操控系统,简化了6自由度串行总线舵机复杂运动控制。

1080P摄像头:感光元件尺寸:1/237”最高有效分辨率:1928*1088;数据格式:YUY2/MJPG;像素大小:3.0μm*3.0μm;宽动态范围:96DB;自动控制:饱和度,对比度,锐度,白平衡,曝光。

机械臂:Cortex-M3内核的处理器控制板,自由度桌面式机械臂,大功率串行总线智能舵机,臂展350mm,负载≥300g,带夹爪,阳极氧化处理铝合金机身,主要用于工业机械臂的控制。支持python编程,可灵活和精准调节每一关节角度和位置;支持PC上位机、手机APP、USB游戏手柄控制;

工程应用方向

机器导航应用

同时定位与地图构建(Simultaneous Localization And Mapping,简称 SLAM),通常 是指在机器人或者其他载体上,通过对各种传感器数据进行采集和计算,生成对其自身位置姿态的定位和场景地图信息的系统。SLAM 技术对于机器人或其他智能体的行动和交互能力至为关键,因为它代表了这种能力的基础:知道自己在哪里,知道周围环境如何,进而知道下一步该如何自主行动。它在自动驾驶、服务型机器人、无人机、AR/VR 等领域有着广泛的应用,可以说凡是拥 有一定行动能力的智能体都拥有某种形式的 SLAM 系统。

视觉导航

AI 视觉/语言/控制多维平台通过多维景深摄像头立体视觉感知完成图像处理,支持 语音识别、背景移除、增加现实、3D 扫描、目标跟踪、面部处理等,实现基于 ROS 系统 的深度摄像 SLAM 导航和构图。

实验内容

移动机器人控制实验

相机标定

动态目标跟随

基础运动控制

机器人驱动系统

视觉巡线

Gmapping建图

激光雷达建图与导航

交通灯识别

交通标志识别

车道识别实验

人脸追踪

机器人检测与感知实验

机器人视觉感知

移动机器人自主定位与姿态传感

移动机器人未知环境感知

移动机器人视觉测距

综合应用课程设计

基于SVM的交通标志识别系统设计

基于深度学习的车道线检测与自适应巡航设计

基于朴素贝叶斯的移动机器人自助避障系统设计

基于循环神经网络的车牌识别系统设计

基于CNN与SVM的交通标志的识别系统设计

基于HOG与SVM的交通标志识别系统设计

基于深度学习的车道线检测系统设计

智能网关:

处理器:64位四核CORTEX-A57,128核MAXWELL GPU;

内存:4GB LPDDR,板载存储:64GB;

接口:USB3.0×4,Micro USB×1, HDMI×1,RJ45×1,DC5.5×2.1电源接口;

集成Linux、Python等运行环境,支持数字图像处理、机器视觉、深度学习等算法、硬件、应用的开发和学习。

搭载 7 寸 LVDS 高清屏。

AI 自动驾驶平台车体不小于 360mm*210mm*350mm,

采用高性能双路 ARM Cortex-M4 STM32G4 控制器单元,

提供电机驱动及传感驱动。

四驱独立悬挂轮式驾驶底盘,大功率减速电机。

(1)运动控制模块

在机器人中用到很多控制器和外设,包括:处理器、激光雷达,STM32控制器,电机、编码器、双路驱动、蓝牙、PS2有线手柄、航模遥控、陀螺仪等,同时提供了串口1和CAN接口方便用户拓展控制,这些控制器与控制器,外设与控制器之间的连接,如图所示。

(2)ROS操作系统

ROS操作系统内置于中央处理器内,通过RTOS完成系统任务调度与管理。具体任务调度管理流程如图所示。RTOS任务调度器根据任务的优先级决定任务的执行顺序,每个任务执行的时间很短,因此几乎等效于所有任务同时执行,期间如果发生中断则去响应中断。串口2中断用于APP蓝牙控制,串口3中断用于接收ROS传过来的信息。

(3)JetsonNano边缘计算平台

NVIDIA Jetson Nano是一个小巧却功能强大的计算机,它可以让你并行运行多个神经网络、对象检测、分割和语音处理等应用程序,Jetson Nano搭载四核cortex-A57处理器,128核MaxwellGPU及4GB LPDDR内存,带来足够的AI计算能力,提供472GFLOP算力,并支持一系列流行的Al框架和算法,比如TensorFlow、Pytorch.caffe/caffe2、Keras、MXNET等

(4)激光雷达

相较于传统技术,利用红外激光设备可实现超大屏幕的多点触摸,其反应更快、精度更高、抗环境光能力更强。激光雷达作为核心传感器,可快速获得环境轮廓信息,配合SLAMWARE使用,可以帮助机器人实现自主构建地图、实时路径规划与自动避开障碍物。应用领域智能扫地机、家用机器人。

测量半径:12米,测量频率:8000次/秒,扫描频率:5.5HZ,360度扫描测距

(5)机器视觉-双目深度体感摄像头

双目深度体感摄像头是VR/AR、机器人和无人驾驶最核心的技术支撑之一,而深度摄像头就是这类硬件的眼睛。只有机器对“看到的”东西,定位定姿精度更高时,才能更好地识别和做出判断,从而提升机器的可用性和产品化速度。利用双目立体视觉成像原理实现三维定位,即可进行手势、肢体动作的综

使用距离:0.8m至 3.5m之间,视野:58° H, 45 V, 70° D(水平,垂直,对角),传感器:深度,深度影像大小:VGA(640x480) : 30fps,QVGA (320x240): 60fps,接口:USB2.0

(7)六自由度机器臂

视觉机械臂以Jetson Nano为主控,Open Source CV为图像处理库,以主流的Jupyter Lab为开发工具,使用Python3为主要编程语言。摄像头与机械臂机身一体式设计,“手眼合一”的视觉识别让机械臂显得更加灵动,它不仅可以实现颜色识别追踪与抓取,还能人体特征识别互动,甚至进行垃圾分类模型训练垃圾分拣;通过RO5机器人操控系统,简化了6自由度串行总线舵机复杂运动控制。

1080P摄像头:感光元件尺寸:1/237”最高有效分辨率:1928*1088;数据格式:YUY2/MJPG;像素大小:3.0μm*3.0μm;宽动态范围:96DB;自动控制:饱和度,对比度,锐度,白平衡,曝光。

机械臂:Cortex-M3内核的处理器控制板,自由度桌面式机械臂,大功率串行总线智能舵机,臂展350mm,负载≥300g,带夹爪,阳极氧化处理铝合金机身,主要用于工业机械臂的控制。支持python编程,可灵活和精准调节每一关节角度和位置;支持PC上位机、手机APP、USB游戏手柄控制;

工程应用方向

机器导航应用

同时定位与地图构建(Simultaneous Localization And Mapping,简称 SLAM),通常 是指在机器人或者其他载体上,通过对各种传感器数据进行采集和计算,生成对其自身位置姿态的定位和场景地图信息的系统。SLAM 技术对于机器人或其他智能体的行动和交互能力至为关键,因为它代表了这种能力的基础:知道自己在哪里,知道周围环境如何,进而知道下一步该如何自主行动。它在自动驾驶、服务型机器人、无人机、AR/VR 等领域有着广泛的应用,可以说凡是拥 有一定行动能力的智能体都拥有某种形式的 SLAM 系统。

视觉导航

AI 视觉/语言/控制多维平台通过多维景深摄像头立体视觉感知完成图像处理,支持 语音识别、背景移除、增加现实、3D 扫描、目标跟踪、面部处理等,实现基于 ROS 系统 的深度摄像 SLAM 导航和构图。

实验内容

移动机器人控制实验

相机标定

动态目标跟随

基础运动控制

机器人驱动系统

视觉巡线

Gmapping建图

激光雷达建图与导航

交通灯识别

交通标志识别

车道识别实验

人脸追踪

机器人检测与感知实验

机器人视觉感知

移动机器人自主定位与姿态传感

移动机器人未知环境感知

移动机器人视觉测距

综合应用课程设计

基于SVM的交通标志识别系统设计

基于深度学习的车道线检测与自适应巡航设计

基于朴素贝叶斯的移动机器人自助避障系统设计

基于循环神经网络的车牌识别系统设计

基于CNN与SVM的交通标志的识别系统设计

基于HOG与SVM的交通标志识别系统设计

基于深度学习的车道线检测系统设计

客户留言

相关产品